增量库表导出

业务场景

用户对已治理数据表进行增量库表导出消费,并通过相关配置避免重试造成数据错乱。

前提条件

- 平台部署完毕,数据开发服务正常;

- 用户拥有批量数据加工模块权限

使用限制

- 仅库表导出节点支持前处理SQL

- 来源表中需有时间字段作为业务时间

- 若已开启业务权限管控,需提前获取对应数据表的相关权限

- 若已开启资源权限管控,需提前获取对应数据源的相关权限

操作流程

第一步:创建数据加工作业

1)在数据开发 > 批量数据 > 数据加工页面新建数据加工作业。

第二步:配置作业参数及增量导出

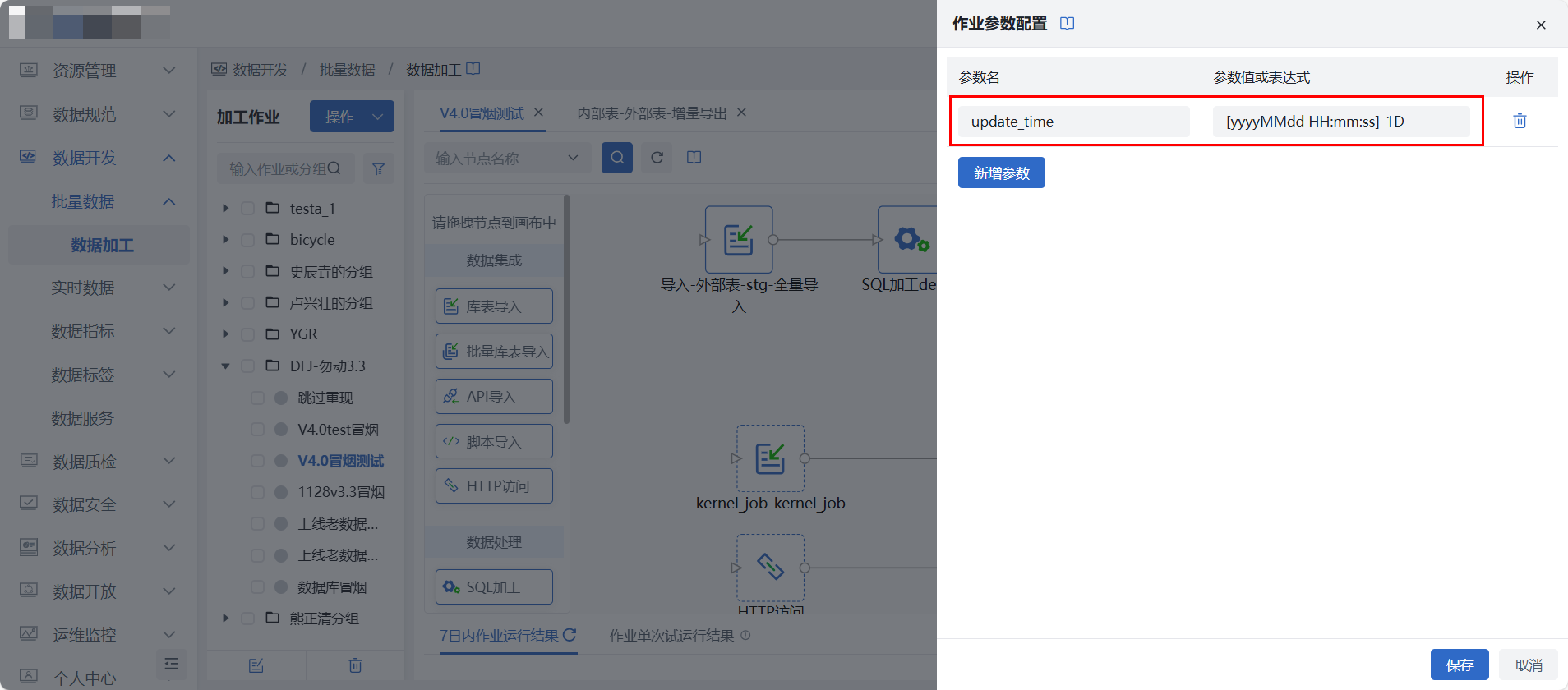

1)在当前作业画布右上角,点击【参数配置】,添加update_time参数,用以进行增量导出数据过滤,及前处理SQL动态传参。

2)在当前作业画布中,拖入【库表导出】节点,并双击节点,进入节点配置页面,选择已开发治理完成的表作为来源表,并选择已在[数据源管理]中注册的目标源作为最终消费对象,更多细节配置可查看库表导出

3)在节点【高级配置】中,设置增量导入过滤语句,并在“前处理SQL中”设置删除数据语句。本实践中调度任务为每天12点调度,以update_time作为业务时间,每次增量导入时,先删除前一天12点到今天的数据,再增量导入,具体配置如下图:

库表导入节点由于没有前处理SQL功能,可通过在导入节点前配置一个【SQL加工】节点,以达到同样效果,删除数据示例语句如下: DELETE FROM tablename WHERE update_time >= #{update_time}

若库表导出为非增量导出,或不设置作业及节点重试,则无需进行相关参数及删除数据语句配置

第三步:配置调度及重试策略

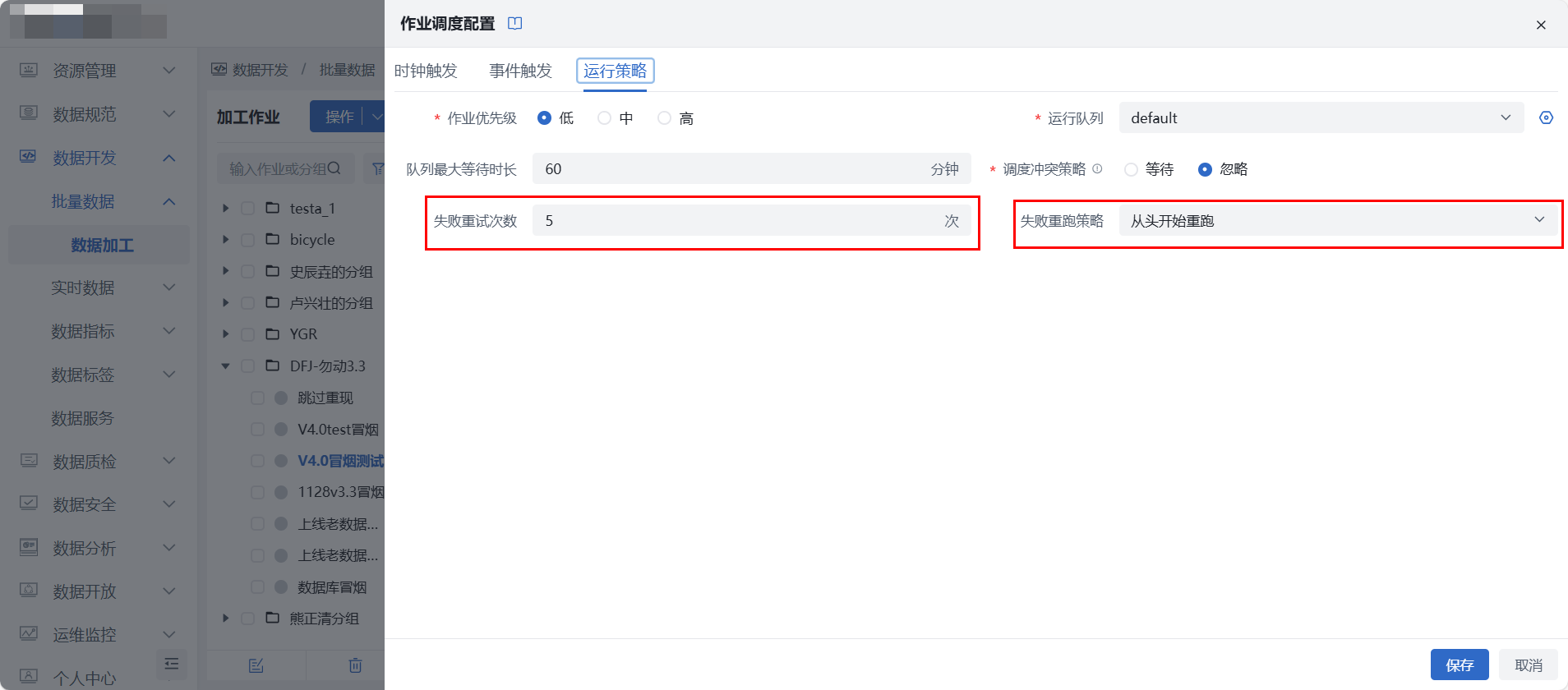

1)在当前作业画布右上角,点击【调度配置】,按本实践需要完成每日12点时钟触发配置后,在“运行策略”中配置重试策略如下图所示,即可保证增量同步时不会因为重试而造成数据错乱。更多细节配置可查看调度配置

- 增量导出时,若需进行重试,请按上方配置作业级重试,请勿配置节点级重试(节点默认不重试,无需专门处理)。

2)完成调度配置后,点击【上线】即可上线作业。

第四步:运维监控

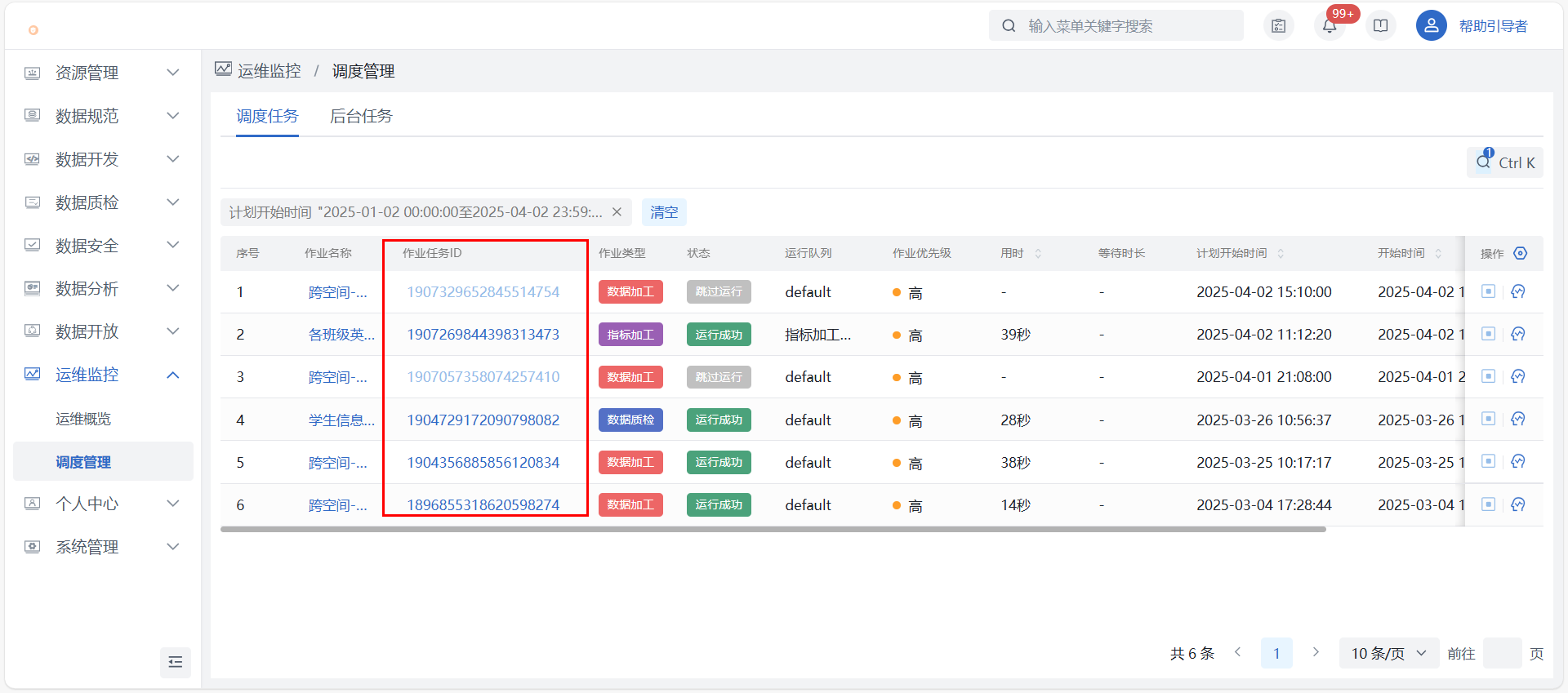

1)调度管理:在运维监控_调度管理找到对应作业,点击【查看作业任务】可查看运行详情,主要信息包含作业任务调度明细、各调度的导出数据量、日志下载、节点任务血缘等。

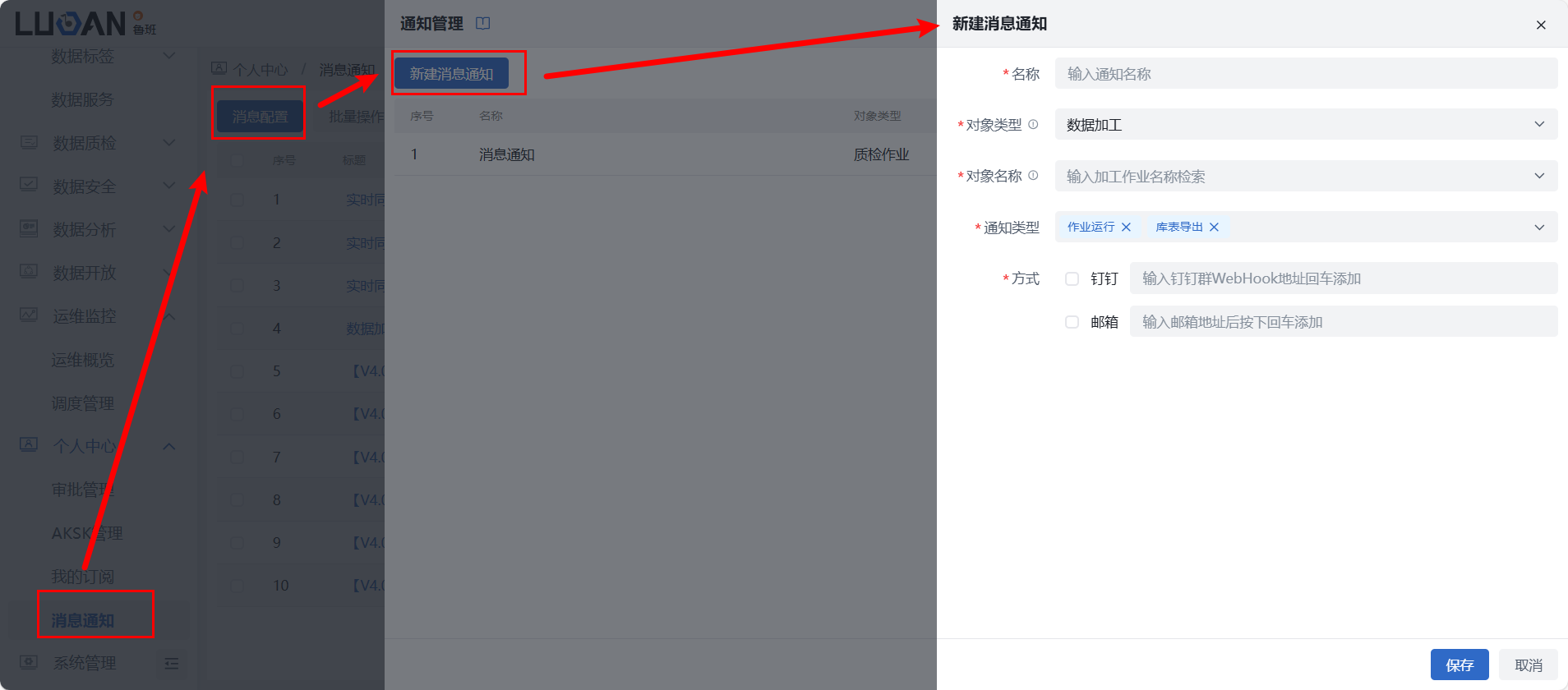

2)告警通知:若需监控作业状态,特别是运行失败,可在个人中心 > 消息通知中配置告警,支持邮件、钉钉群通知。对象类型选择“数据加工”、对象名称填写需监控的作业名称,通知类型选择“作业运行”,作业运行失败时,可发送消息通知。

2)告警通知:若需监控作业状态,特别是运行失败,可在个人中心 > 消息通知中配置告警,支持邮件、钉钉群通知。对象类型选择“数据加工”、对象名称填写需监控的作业名称,通知类型选择“作业运行”,作业运行失败时,可发送消息通知。